- AnatomyEdit

- Słuchowy strumień brzusznyEdit

- Rozpoznawanie dźwiękuEdit

- Rozumienie zdańEdit

- DwustronnośćEdit

- Słuchowy strumień grzbietowyEdit

- Produkcja mowyEdit

- Mimika wokalnaEdit

- Monitorowanie mowyEdit

- Integracja fonemów z ruchami wargEdit

- Fonologiczna pamięć długotrwałaEdit

- Fonologiczna pamięć roboczaEdit

AnatomyEdit

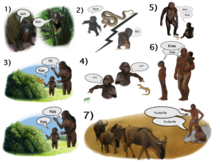

W ciągu ostatnich dwóch dekad nastąpił znaczący postęp w naszym rozumieniu neuronalnego przetwarzania dźwięków u naczelnych. Początkowo poprzez rejestrację aktywności neuronalnej w korze słuchowej małp, a następnie rozwiniętej poprzez barwienie histologiczne i skanowanie fMRI, zidentyfikowano 3 pola słuchowe w pierwotnej korze słuchowej i 9 asocjacyjnych pól słuchowych, które je otaczają (rysunek 1 u góry po lewej). Śledzenie anatomiczne i badania zmian chorobowych wskazały na oddzielenie przednich i tylnych pól słuchowych, z przednimi pierwszorzędowymi polami słuchowymi (obszary R-RT) rzutującymi na przednie asocjacyjne pola słuchowe (obszary AL-RTL) oraz z tylnymi pierwszorzędowymi polami słuchowymi (obszar A1) rzutującymi na tylne asocjacyjne pola słuchowe (obszary CL-CM). Ostatnio zgromadzono dowody wskazujące na homologię między polami słuchowymi człowieka i małpy. U ludzi, badania histologiczne ujawniły dwa oddzielne pola słuchowe w pierwotnym obszarze słuchowym zakrętu Heschla, a poprzez mapowanie organizacji tonotopowej ludzkich pierwotnych pól słuchowych za pomocą fMRI o wysokiej rozdzielczości i porównanie jej z organizacją tonotopową pierwotnych pól słuchowych małp, ustalono homologię pomiędzy ludzkim przednim pierwotnym polem słuchowym i małpim obszarem R (oznaczanym u ludzi jako obszar hR) oraz ludzkim tylnym pierwotnym polem słuchowym i małpim obszarem A1 (oznaczanym u ludzi jako obszar hA1). Wewnątrzkorowe zapisy z ludzkiej kory słuchowej wykazały podobne wzorce połączeń z korą słuchową małpy. Nagrania z powierzchni kory słuchowej (płaszczyzna nadskroniowa) wykazały, że przedni zakręt Heschla (obszar hR) oddziałuje głównie ze środkowo-przednim górnym zakrętem skroniowym (mSTG-aSTG), a tylny zakręt Heschla (obszar hA1) oddziałuje głównie z tylnym górnym zakrętem skroniowym (pSTG) i planum temporale (obszar PT; Rycina 1 u góry po prawej). Zgodne z połączeniami z obszaru hR do aSTG i hA1 do pSTG jest badanie fMRI pacjenta z zaburzeniami rozpoznawania dźwięków (agnozja słuchowa), u którego wykazano zmniejszoną obustronną aktywację w obszarach hR i aSTG, ale z zachowaną aktywacją w mSTG-pSTG. Ten wzór połączeń jest również potwierdzony przez badania, w których rejestrowano aktywację z bocznej powierzchni kory słuchowej i odnotowano jednoczesne, nie nakładające się na siebie skupiska aktywacji w pSTG i mSTG-aSTG podczas słuchania dźwięków.

Downstream do kory słuchowej, badania anatomiczne u małp wytyczyły projekcje z przednich asocjacyjnych pól słuchowych (obszary AL-RTL) do brzusznej kory przedczołowej i przedruchowej w dolnym zakręcie czołowym (IFG) i amygdali. Badania korowej rejestracji i funkcjonalnego obrazowania u małp makaków rozwinęły ten strumień przetwarzania, pokazując, że informacja akustyczna przepływa z przedniej części kory słuchowej do bieguna skroniowego (TP), a następnie do IFG. Droga ta jest powszechnie określana jako słuchowy strumień brzuszny (AVS; rysunek 1, na dole po lewej – czerwone strzałki). W przeciwieństwie do przednich pól słuchowych, badania tracingowe wykazały, że tylne pola słuchowe (obszary CL-CM) rzutują przede wszystkim do grzbietowo-bocznej kory przedczołowej i przedruchowej (choć niektóre projekcje kończą się w IFG). Nagrania korowe i badania anatomiczne na małpach dostarczyły dalszych dowodów na to, że ten strumień przetwarzania przepływa z tylnych pól słuchowych do płata czołowego przez stację przekaźnikową w bruździe śródciemieniowej (IPS). Droga ta jest powszechnie określana jako słuchowy strumień grzbietowy (ADS; Rycina 1, lewy dolny róg – niebieskie strzałki). Porównanie szlaków istoty białej zaangażowanych w komunikację u ludzi i małp za pomocą technik obrazowania tensora dyfuzji wskazuje na podobne połączenia AVS i ADS u obu gatunków (Monkey, Human). U ludzi wykazano, że pSTG rzutuje się do płata ciemieniowego (sylwian parietal-temporal junction-inferior parietal lobule; Spt-IPL), a stamtąd do grzbietowo-bocznej kory przedczołowej i przedruchowej (rysunek 1, dolne prawe strzałki niebieskie), a aSTG rzutuje do przedniego płata skroniowego (środkowa część zakrętu skroniowego – biegun skroniowy; MTG-TP), a stamtąd do IFG (rysunek 1, dolne prawe strzałki czerwone).

Słuchowy strumień brzusznyEdit

Słuchowy strumień brzuszny (AVS) łączy korę słuchową ze środkowym zakrętem skroniowym i biegunem skroniowym, który z kolei łączy się z dolnym zakrętem czołowym. Ta ścieżka jest odpowiedzialna za rozpoznawanie dźwięków i jest odpowiednio znana jako słuchowa ścieżka „co”. Funkcje AVS obejmują następujące funkcje.

Rozpoznawanie dźwiękuEdit

Kumulacja zbieżnych dowodów wskazuje, że AVS jest zaangażowany w rozpoznawanie obiektów słuchowych. Na poziomie pierwotnej kory słuchowej, nagrania z małp wykazały wyższy odsetek neuronów selektywnych dla wyuczonych sekwencji melodycznych w obszarze R niż w obszarze A1, a badania u ludzi wykazały większą selektywność dla usłyszanych sylab w przednim zakręcie Heschla (obszar hR) niż w tylnym zakręcie Heschla (obszar hA1). W dalszych asocjacyjnych polach słuchowych, badania zarówno małp jak i ludzi wykazały, że granica między przednim i tylnym polem słuchowym (rysunek 1 – obszar PC u małpy i mSTG u człowieka) przetwarza atrybuty wysokości dźwięku, które są niezbędne do rozpoznawania obiektów słuchowych. Wykazano również, że przednie pola słuchowe małp wykazują selektywność dla wokalizacji specyficznych dla kongruencji za pomocą nagrań wewnątrzkorowych. i obrazowania funkcjonalnego Jedno z badań fMRI na małpach dodatkowo wykazało rolę aSTG w rozpoznawaniu poszczególnych głosów. Rola ludzkiego mSTG-aSTG w rozpoznawaniu dźwięków została wykazana w badaniach obrazowania funkcjonalnego, które skorelowały aktywność w tym regionie z izolacją obiektów słuchowych od szumu tła oraz z rozpoznawaniem słów mówionych, głosów, melodii, dźwięków otoczenia i dźwięków komunikacyjnych innych niż mowa. Metaanaliza badań fMRI wykazała ponadto funkcjonalną dysocjację pomiędzy lewym mSTG i aSTG, gdzie pierwszy z nich przetwarza krótkie jednostki mowy (fonemy), a drugi dłuższe jednostki (np. słowa, dźwięki otoczenia). Badanie, w którym rejestrowano aktywność neuronalną bezpośrednio z lewego pSTG i aSTG wykazało, że aSTG, ale nie pSTG, było bardziej aktywne, gdy pacjentka słuchała mowy w języku ojczystym niż nieznanym języku obcym. Konsekwentnie, elektrostymulacja do aSTG u tej pacjentki powodowała zaburzenia percepcji mowy (zobacz również podobne wyniki). Wewnątrzkorowe zapisy z prawej i lewej aSTG dodatkowo wykazały, że mowa jest przetwarzana lateralnie do muzyki. W badaniu fMRI pacjenta z zaburzeniami rozpoznawania dźwięków (agnozja słuchowa) spowodowanymi uszkodzeniem pnia mózgu wykazano również zmniejszoną aktywację w obszarach hR i aSTG obu półkul podczas słyszenia słów mówionych i dźwięków otoczenia. Nagrania z przedniej kory słuchowej małp podczas utrzymywania wyuczonych dźwięków w pamięci roboczej oraz osłabiający wpływ indukowanych uszkodzeń tego regionu na pamięć roboczą, dodatkowo implikują udział AVS w utrzymywaniu postrzeganych obiektów słuchowych w pamięci roboczej. U ludzi, obszar mSTG-aSTG był również aktywny podczas powtarzania usłyszanych sylab za pomocą MEG i fMRI. To ostatnie badanie wykazało, że pamięć robocza w AVS dotyczy akustycznych właściwości wypowiadanych słów i że jest niezależna od pamięci roboczej w ADS, która pośredniczy w mowie wewnętrznej. Badania pamięci roboczej u małp sugerują również, że u małp, w przeciwieństwie do ludzi, AVS jest dominującym magazynem pamięci roboczej.

U ludzi, niżej niż aSTG, uważa się, że MTG i TP tworzą leksykon semantyczny, który jest repozytorium pamięci długoterminowej audio-wizualnych reprezentacji, które są połączone na podstawie relacji semantycznych. (Zob. też recenzje omawiające ten temat). Podstawowym dowodem na taką rolę MTG-TP jest fakt, że u pacjentów z uszkodzeniem tego regionu (np. u pacjentów z otępieniem semantycznym lub zapaleniem mózgu wywołanym wirusem opryszczki zwykłej) stwierdza się upośledzoną zdolność opisywania obiektów wzrokowych i słuchowych oraz tendencję do popełniania błędów semantycznych przy nazywaniu obiektów (tzw. parafazja semantyczna). Parafazje semantyczne były również wyrażane przez pacjentów z afazją z uszkodzeniem lewego MTG-TP i wykazano ich występowanie u pacjentów bez afazji po elektrostymulacji tego regionu. lub leżącej u jej podłoża drogi istoty białej Dwie metaanalizy literatury dotyczącej fMRI również donoszą, że przednia MTG i TP były konsekwentnie aktywne podczas semantycznej analizy mowy i tekstu; a badanie zapisu wewnątrzkorowego korelowało wyładowania neuronalne w MTG ze zrozumieniem zrozumiałych zdań.

Rozumienie zdańEdit

Oprócz wydobywania znaczenia z dźwięków, region MTG-TP w AVS wydaje się mieć rolę w rozumieniu zdań, prawdopodobnie poprzez łączenie pojęć razem (np, łączenie pojęć „niebieski” i „koszula” w celu stworzenia pojęcia „niebieskiej koszuli”). Rola MTG w wydobywaniu znaczenia ze zdań została wykazana w badaniach obrazowania funkcjonalnego, w których odnotowano silniejszą aktywację w przedniej części MTG, gdy właściwe zdania są zestawiane z listami słów, zdaniami w języku obcym lub nonsensownym, zdaniami zakodowanymi, zdaniami z naruszeniami semantycznymi lub składniowymi oraz podobnymi do zdań sekwencjami dźwięków otoczenia. Jedno z badań fMRI, w którym uczestnikom polecono przeczytanie opowiadania, dodatkowo korelowało aktywność w przedniej części MTG z ilością treści semantycznej i składniowej, jaką zawierało każde zdanie. W badaniu EEG, w którym porównywano aktywność korową podczas czytania zdań z i bez naruszeń składni u zdrowych uczestników i pacjentów z uszkodzeniem MTG-TP, stwierdzono, że MTG-TP w obu półkulach bierze udział w automatycznym (opartym na regułach) etapie analizy składniowej (komponent ELAN) oraz że lewa MTG-TP jest również zaangażowana w późniejszy, kontrolowany etap analizy składniowej (komponent P600). U pacjentów z uszkodzeniem regionu MTG-TP odnotowano również zaburzenia rozumienia zdań. Więcej informacji na ten temat można znaleźć w przeglądzie.

DwustronnośćEdit

W przeciwieństwie do modelu Wernickego-Lichtheima-Geschwinda, który zakłada, że rozpoznawanie dźwięków zachodzi wyłącznie w lewej półkuli, badania, w których badano właściwości prawej lub lewej półkuli w izolacji poprzez jednostronne znieczulenie półkulowe (tj. procedura WADA) lub zapisy wewnątrzkorowe z każdej półkuli, dostarczyły dowodów na to, że rozpoznawanie dźwięków jest przetwarzane dwustronnie. Ponadto, w badaniu, w którym pacjentom z rozłączonymi półkulami (tj. pacjentom z rozszczepieniem mózgu) polecono dopasować słowa mówione do słów pisanych prezentowanych w prawym lub lewym polu półkulowym, stwierdzono, że słownictwo w prawej półkuli prawie dorównuje słownictwu w lewej półkuli (słownictwo prawej półkuli odpowiadało słownictwu zdrowego 11-letniego dziecka). To obustronne rozpoznawanie dźwięków jest również zgodne z odkryciem, że jednostronne uszkodzenie kory słuchowej rzadko skutkuje deficytem rozumienia dźwięków (tj. agnozją słuchową), podczas gdy drugie uszkodzenie pozostałej półkuli (które może wystąpić wiele lat później) już tak. Wreszcie, jak wspomniano wcześniej, skan fMRI pacjenta z agnozją słuchową wykazał obustronnie zmniejszoną aktywację w przedniej części kory słuchowej, a obustronna elektrostymulacja tych regionów w obu półkulach skutkowała upośledzeniem rozpoznawania mowy.

Słuchowy strumień grzbietowyEdit

Słuchowy strumień grzbietowy łączy korę słuchową z płatem ciemieniowym, który z kolei łączy się z dolnym zakrętem czołowym. Zarówno u ludzi, jak i u ssaków naczelnych, słuchowy strumień grzbietowy jest odpowiedzialny za lokalizację dźwięku i jest odpowiednio znany jako słuchowa ścieżka „gdzie”. U ludzi, ścieżka ta (zwłaszcza w lewej półkuli) jest również odpowiedzialna za produkcję mowy, powtarzanie mowy, czytanie z ruchu warg oraz fonologiczną pamięć roboczą i pamięć długotrwałą.

Produkcja mowyEdit

Badania współczesnych ludzi wykazały rolę ADS w produkcji mowy, zwłaszcza w wokalnej ekspresji nazw przedmiotów. Na przykład, w serii badań, w których włókna podkorowe były bezpośrednio stymulowane, zakłócenia w lewym pSTG i IPL powodowały błędy podczas zadań nazywania obiektów, a zakłócenia w lewym IFG powodowały zatrzymanie mowy. Zakłócenia magnetyczne w pSTG i IFG u zdrowych uczestników również powodowały błędy w mowie i zatrzymanie mowy. W jednym z badań wykazano, że elektryczna stymulacja lewego IPL powodowała, że pacjenci wierzyli, że mówili, podczas gdy nie mówili, a stymulacja IFG powodowała, że pacjenci nieświadomie poruszali wargami. Udział ADS w procesie artykulacji nazw przedmiotów może zależeć od odbioru aferentów z leksykonu semantycznego AVS, Jako że wewnątrzkorowe badania nagraniowe donoszą o aktywacji w tylnej MTG przed aktywacją w regionie Spt-IPL, kiedy pacjenci nazywali obiekty na obrazach, wewnątrzkorowe badania stymulacji elektrycznej również donoszą, że elektryczne zakłócenia w tylnej MTG były skorelowane z upośledzonym nazywaniem obiektów

Mimika wokalnaEdit

Pomimo że percepcja dźwięku jest przypisywana głównie AVS, ADS wydaje się być związana z kilkoma aspektami percepcji mowy. Na przykład, w metaanalizie badań fMRI (Turkeltaub i Coslett, 2010), w których słuchowa percepcja fonemów została skontrastowana z blisko pasującymi dźwiękami, a badania zostały ocenione pod względem wymaganego poziomu uwagi, autorzy doszli do wniosku, że uwaga na fonach koreluje z silną aktywacją w regionie pSTG-pSTS. W badaniu z zapisem wewnątrzkorowym, w którym uczestnicy byli instruowani, by identyfikować sylaby, również skorelowano słyszenie każdej sylaby z jej własnym wzorcem aktywacji w pSTG. Zaangażowanie ADS zarówno w percepcję, jak i produkcję mowy zostało dodatkowo naświetlone w kilku pionierskich badaniach obrazowania funkcjonalnego, które kontrastowały percepcję mowy z jawną lub ukrytą produkcją mowy. Badania te wykazały, że pSTS jest aktywny tylko podczas percepcji mowy, podczas gdy obszar Spt jest aktywny zarówno podczas percepcji, jak i produkcji mowy. Autorzy doszli do wniosku, że pSTS projektuje do obszaru Spt, który przetwarza sygnał słuchowy na ruchy artykulacyjne. Podobne wyniki uzyskano w badaniu, w którym stymulowano elektrycznie płaty skroniowe i ciemieniowe uczestników. W pracy tej wykazano, że stymulacja elektryczna obszaru pSTG zaburza rozumienie zdań, a stymulacja IPL zaburza zdolność do wokalizowania nazw przedmiotów. Autorzy donoszą również, że stymulacja obszaru Spt i dolnej części IPL wywołuje interferencję zarówno podczas zadań związanych z nazywaniem przedmiotów, jak i rozumieniem mowy. Rola ADS w powtarzaniu mowy jest również zgodna z wynikami innych badań obrazowania funkcjonalnego, które lokalizowały aktywację w regionach ADS podczas zadań powtarzania mowy. Wewnątrzkorowe badania, które rejestrowały aktywność w większości płatów skroniowych, ciemieniowych i czołowych, wykazały również aktywację w pSTG, Spt, IPL i IFG, gdy powtarzanie mowy jest skontrastowane z percepcją mowy. Badania neuropsychologiczne wykazały również, że osoby z deficytem powtarzania mowy, ale zachowanym rozumieniem ze słuchu (tj. afazja przewodzenia) cierpią na obwodowe uszkodzenie obszaru Spt-IPL lub uszkodzenie projekcji, które emanują z tego obszaru i są skierowane do płata czołowego Badania wykazały również przejściowy deficyt powtarzania mowy u pacjentów po bezpośredniej wewnątrzkorowej stymulacji elektrycznej tego samego obszaru. Wgląd w cel powtarzania mowy w ADS zapewniają badania podłużne dzieci, które korelowały uczenie się obcego słownictwa ze zdolnością do powtarzania bezsensownych słów.

Monitorowanie mowyEdit

Oprócz powtarzania i wytwarzania mowy, ADS wydaje się pełnić rolę w monitorowaniu jakości mowy wyjściowej. Neuroanatomiczne dowody sugerują, że ADS jest wyposażony w zstępujące połączenia z IFG do pSTG, które przekazują informacje o aktywności motorycznej (tj. wyładowaniach współruchowych) w aparacie głosowym (usta, język, fałdy głosowe). To sprzężenie zwrotne oznacza, że dźwięk postrzegany podczas produkcji mowy jest wytwarzany samodzielnie i może być wykorzystany do regulacji aparatu głosowego w celu zwiększenia podobieństwa między postrzeganym a emitowanym głosem. Dowody na istnienie zstępujących połączeń z IFG do pSTG pochodzą z badania, w którym elektrycznie stymulowano IFG podczas operacji chirurgicznych i odnotowano rozprzestrzenianie się aktywacji do regionu pSTG-pSTS-Spt Badanie, w którym porównywano zdolność pacjentów z afazją z płatami czołowymi, Uszkodzenie płatów czołowych, ciemieniowych lub skroniowych do szybkiej i wielokrotnej artykulacji ciągu sylab wykazało, że uszkodzenie płatów czołowych zaburza artykulację zarówno identycznych ciągów sylab („Bababa”), jak i nieidentycznych ciągów sylab („Badaga”), podczas gdy pacjenci z uszkodzeniem płatów skroniowych lub ciemieniowych wykazywali upośledzenie tylko przy artykulacji nieidentycznych ciągów sylab. Ponieważ pacjenci z uszkodzeniem płatów skroniowych i ciemieniowych byli w stanie powtórzyć ciąg sylabiczny w pierwszym zadaniu, ich percepcja i produkcja mowy wydaje się być względnie zachowana, a ich deficyt w drugim zadaniu wynika z zaburzonego monitorowania. Demonstrując rolę zstępujących połączeń ADS w monitorowaniu emitowanych rozmów, w badaniu fMRI polecono uczestnikom mówić w normalnych warunkach lub słysząc zmodyfikowaną wersję własnego głosu (opóźniony pierwszy formant) i wykazano, że słyszenie zniekształconej wersji własnego głosu powoduje zwiększoną aktywację w pSTG. Kolejnym dowodem na to, że ADS ułatwia motoryczne sprzężenie zwrotne podczas naśladownictwa, jest badanie z rejestracją wewnątrzkorową, w którym porównywano percepcję mowy i jej powtarzanie. Autorzy donoszą, że oprócz aktywacji w IPL i IFG, powtarzanie mowy charakteryzuje się silniejszą aktywacją w pSTG niż podczas percepcji mowy.

Integracja fonemów z ruchami wargEdit

Ale percepcja dźwięku jest przypisywana głównie AVS, ADS wydaje się być związana z kilkoma aspektami percepcji mowy. Na przykład, w meta-analizie badań fMRI, w których słuchowa percepcja fonemów była skontrastowana z blisko pasującymi dźwiękami, a badania były oceniane pod względem wymaganego poziomu uwagi, autorzy doszli do wniosku, że uwaga na fonach koreluje z silną aktywacją w regionie pSTG-pSTS. W badaniu z zapisem wewnątrzkorowym, w którym uczestnicy byli instruowani, by identyfikować sylaby, również skorelowano słyszenie każdej sylaby z jej własnym wzorem aktywacji w pSTG. Zgodnie z rolą ADS w rozróżnianiu fonemów, badania przypisały integrację fonemów i odpowiadających im ruchów warg (tj. wizji) do pSTS ADS. Na przykład, badanie fMRI skorelowało aktywację w pSTS z iluzją McGurka (w której słyszenie sylaby „ba” przy jednoczesnym widzeniu wizji „ga” skutkuje percepcją sylaby „da”). Inne badanie wykazało, że zastosowanie stymulacji magnetycznej w celu zakłócenia przetwarzania w tym obszarze jeszcze bardziej zakłóca iluzję McGurka. Związek pSTS z audiowizualną integracją mowy został również wykazany w badaniu, w którym uczestnikom prezentowano obrazy twarzy i wypowiadane słowa o różnej jakości. Badanie wykazało, że pSTS selekcjonuje połączony wzrost wyrazistości twarzy i wypowiadanych słów. Potwierdzających dowodów dostarczyło badanie fMRI, w którym porównywano percepcję audiowizualnej mowy z audiowizualnymi nie-mowami (obrazami i dźwiękami narzędzi). Badanie to wykazało wykrycie selektywnych pod względem mowy kompartmentów w pSTS. Ponadto w badaniu fMRI, w którym skontrastowano mowę audiowizualną zgodną z mową niezgodną (obrazy nieruchomych twarzy), odnotowano aktywację pSTS. Przegląd dodatkowych, zbieżnych dowodów dotyczących roli pSTS i ADS w integracji fonem-viseme znajduje się w

Fonologiczna pamięć długotrwałaEdit

Rosnąca liczba dowodów wskazuje, że ludzie, oprócz posiadania długoterminowego magazynu znaczeń słów zlokalizowanego w MTG-TP AVS (tj, leksykon semantyczny), posiada również długoterminowy zasób nazw obiektów zlokalizowany w regionie Spt-IPL w ADS (leksykon fonologiczny). Na przykład, badania przeprowadzone na pacjentach z uszkodzeniem AVS (uszkodzenie MTG) lub ADS (uszkodzenie IPL) wykazały, że uszkodzenie MTG powoduje, że osoby nieprawidłowo identyfikują obiekty (np. nazywają „kozę” „owcą”, co jest przykładem parafazji semantycznej). I odwrotnie, uszkodzenie IPL powoduje, że osoby prawidłowo identyfikują obiekt, ale nieprawidłowo wymawiają jego nazwę (np. wymawiają „gof” zamiast „goat”, co jest przykładem parafazji fonemowej). Błędy parafazji semantycznej były również zgłaszane u pacjentów otrzymujących wewnątrzkorową stymulację elektryczną AVS (MTG), a błędy parafazji fonemowej były zgłaszane u pacjentów, u których ADS (pSTG, Spt i IPL) otrzymywały wewnątrzkorową stymulację elektryczną. Dalsze wsparcie dla roli ADS w nazywaniu obiektów stanowi badanie MEG, w którym zlokalizowano aktywność w IPL podczas uczenia się i przypominania nazw obiektów. W badaniu, w którym indukowano zakłócenia magnetyczne w IPL uczestników, podczas gdy odpowiadali oni na pytania dotyczące obiektu, stwierdzono, że uczestnicy byli w stanie odpowiedzieć na pytania dotyczące cech obiektu lub atrybutów percepcyjnych, ale byli upośledzeni, gdy pytano ich, czy słowo zawiera dwie czy trzy sylaby. W badaniu MEG skorelowano również powrót do zdrowia po anomii (zaburzenie charakteryzujące się upośledzoną zdolnością do nazywania obiektów) ze zmianami w aktywacji IPL. Badania, które dodatkowo potwierdzają rolę IPL w kodowaniu dźwięków słów, wykazały, że w porównaniu z osobami jednojęzycznymi dwujęzyczni mają większą gęstość korową w IPL, ale nie w MTG. Ponieważ dowody wskazują, że u dwujęzycznych różne reprezentacje fonologiczne tego samego słowa mają tę samą reprezentację semantyczną, ten wzrost gęstości w IPL weryfikuje istnienie leksykonu fonologicznego: oczekuje się, że leksykon semantyczny dwujęzycznych będzie miał podobny rozmiar do leksykonu semantycznego jednojęzycznych, podczas gdy ich leksykon fonologiczny powinien być dwa razy większy. Zgodnie z tym odkryciem, gęstość korowa w IPL u jednojęzycznych również koreluje z wielkością słownictwa. Warto zauważyć, że funkcjonalna dysocjacja AVS i ADS w zadaniach nazywania obiektów jest wspierana przez łączne dowody z badań nad czytaniem pokazujące, że błędy semantyczne są skorelowane z upośledzeniem MTG, a błędy foniczne z upośledzeniem IPL. Na podstawie tych skojarzeń semantyczna analiza tekstu została powiązana z zakrętem dolno-skroniowym i MTG, a fonologiczna analiza tekstu została powiązana z pSTG-Spt- IPL

Fonologiczna pamięć roboczaEdit

Pamięć robocza jest często traktowana jako tymczasowa aktywacja reprezentacji przechowywanych w pamięci długotrwałej, które są używane w mowie (reprezentacje fonologiczne). To współdzielenie zasobów między pamięcią roboczą a mową jest widoczne w stwierdzeniu, że mówienie podczas próby powoduje znaczące zmniejszenie liczby pozycji, które mogą być przywołane z pamięci roboczej (tłumienie artykulacyjne). O zaangażowaniu leksykonu fonologicznego w pamięć roboczą świadczy również tendencja do popełniania większej liczby błędów przy przywoływaniu słów z niedawno poznanej listy słów fonologicznie podobnych niż z listy słów fonologicznie niepodobnych (efekt podobieństwa fonologicznego). Badania wykazały również, że błędy w mowie popełniane podczas czytania są niezwykle podobne do błędów popełnianych podczas przywoływania z pamięci roboczej niedawno poznanych, podobnych fonologicznie słów. Wreszcie, pogląd, że werbalna pamięć robocza jest wynikiem tymczasowej aktywacji reprezentacji fonologicznych w ADS, jest zgodny z najnowszymi modelami opisującymi pamięć roboczą jako połączenie utrzymywania reprezentacji w mechanizmie uwagi równolegle z tymczasową aktywacją reprezentacji w pamięci długotrwałej. Argumentowano, że rola ADS w rehearsal list słów jest powodem, dla którego ścieżka ta jest aktywna podczas rozumienia zdań Przegląd roli ADS w pamięci roboczej, zob.