- AnatomieBearbeiten

- Auditiver ventraler StromBearbeiten

- GeräuscherkennungBearbeiten

- SatzverständnisBearbeiten

- BilateralitätBearbeiten

- Auditiver dorsaler StromEdit

- SprachproduktionBearbeiten

- Vocal mimicryEdit

- SprachüberwachungBearbeiten

- Integration von Phonemen mit LippenbewegungenEdit

- Phonologisches LangzeitgedächtnisEdit

- Phonologisches ArbeitsgedächtnisEdit

AnatomieBearbeiten

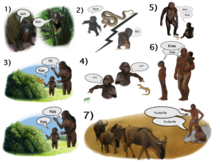

In den letzten zwei Jahrzehnten wurden bedeutende Fortschritte in unserem Verständnis der neuronalen Verarbeitung von Klängen bei Primaten erzielt. Zunächst durch Aufzeichnung der neuronalen Aktivität in den Hörrinden von Affen und später durch histologische Färbung und fMRI-Scanstudien wurden 3 Hörfelder in der primären Hörrinde identifiziert, und es wurde gezeigt, dass sie von 9 assoziativen Hörfeldern umgeben sind (Abbildung 1 oben links). Anatomische Tracing- und Läsionsstudien wiesen außerdem auf eine Trennung zwischen den vorderen und hinteren Hörfeldern hin, wobei die vorderen primären Hörfelder (Bereiche R-RT) auf die vorderen assoziativen Hörfelder (Bereiche AL-RTL) und das hintere primäre Hörfeld (Bereich A1) auf die hinteren assoziativen Hörfelder (Bereiche CL-CM) projiziert. In letzter Zeit häufen sich die Hinweise auf eine Homologie zwischen dem menschlichen und dem Affen-Hörfeld. Beim Menschen ergaben histologische Färbestudien zwei getrennte Hörfelder in der primären Hörregion des Gyrus Heschl, und durch die Kartierung der tonotopischen Organisation der primären Hörfelder des Menschen mit hochauflösender fMRT und den Vergleich mit der tonotopischen Organisation der primären Hörfelder des Affen wurde eine Homologie zwischen dem vorderen primären Hörfeld des Menschen und dem Affengebiet R (beim Menschen als Gebiet hR bezeichnet) und dem hinteren primären Hörfeld des Menschen und dem Affengebiet A1 (beim Menschen als Gebiet hA1 bezeichnet) festgestellt. Intrakortikale Aufzeichnungen aus dem menschlichen Hörkortex zeigten außerdem ähnliche Konnektivitätsmuster wie im Hörkortex des Affen. Aufzeichnungen von der Oberfläche des auditorischen Kortex (supra-temporale Ebene) ergaben, dass der anteriore Gyrus Heschl (Areal hR) in erster Linie in den mittleren-anterioren superioren temporalen Gyrus (mSTG-aSTG) und der posteriore Gyrus Heschl (Areal hA1) in erster Linie in den posterioren superioren temporalen Gyrus (pSTG) und das Planum temporale (Areal PT; Abbildung 1 oben rechts) projiziert. Eine fMRT-Studie an einem Patienten mit gestörter Geräuscherkennung (auditorische Agnosie), bei dem eine reduzierte bilaterale Aktivierung in den Arealen hR und aSTG, aber eine verschonte Aktivierung im mSTG-pSTG festgestellt wurde, zeigt, dass Verbindungen vom Areal hR zum aSTG und hA1 zum pSTG bestehen. Dieses Konnektivitätsmuster wird auch durch eine Studie bestätigt, in der die Aktivierung von der lateralen Oberfläche des auditorischen Kortex aufgezeichnet wurde und von gleichzeitigen, sich nicht überlappenden Aktivierungsclustern im pSTG und mSTG-aSTG beim Hören von Geräuschen berichtet wurde.

Im Anschluss an den auditorischen Kortex wurden in anatomischen Tracing-Studien an Affen Projektionen von den vorderen assoziativen auditorischen Feldern (Bereiche AL-RTL) zu ventralen präfrontalen und prämotorischen Kortizes im inferioren frontalen Gyrus (IFG) und der Amygdala beschrieben. Studien mit kortikalen Aufzeichnungen und funktioneller Bildgebung an Makakenaffen haben diesen Verarbeitungsstrom weiter ausgearbeitet und gezeigt, dass akustische Informationen vom anterioren auditorischen Kortex zum temporalen Pol (TP) und dann zum IFG fließen. Dieser Weg wird gemeinhin als auditiver ventraler Strom (AVS; Abbildung 1, unten links – rote Pfeile) bezeichnet. Im Gegensatz zu den vorderen Hörfeldern projizieren die hinteren Hörfelder (Bereiche CL-CM) laut Tracing-Studien hauptsächlich in den dorsolateralen präfrontalen und prämotorischen Kortex (obwohl einige Projektionen im IFG enden). Kortikale Aufzeichnungen und anatomische Tracing-Studien an Affen erbrachten den Nachweis, dass dieser Verarbeitungsstrom von den hinteren Hörfeldern über eine Relaisstation im intraparietalen Sulcus (IPS) zum Frontallappen fließt. Diese Bahn wird gemeinhin als auditiver dorsaler Strom (ADS; Abbildung 1, unten links – blaue Pfeile) bezeichnet. Ein Vergleich der an der Kommunikation beteiligten Bahnen der weißen Substanz bei Menschen und Affen mit Diffusions-Tensor-Imaging-Techniken zeigt, dass die Verbindungen des AVS und des ADS bei beiden Spezies (Affe, Mensch) ähnlich sind. Beim Menschen wurde gezeigt, dass das pSTG in den Parietallappen projiziert (sylvian parietal-temporal junction-inferior parietal lobule; Spt-IPL) und von dort in den dorsolateralen präfrontalen und prämotorischen Kortex (Abbildung 1, unten rechts – blaue Pfeile), und das aSTG projiziert in den vorderen Temporallappen (mittlerer temporaler Gyrus – temporaler Pol; MTG-TP) und von dort in das IFG (Abbildung 1 unten rechts – rote Pfeile).

Auditiver ventraler StromBearbeiten

Der auditive ventrale Strom (AVS) verbindet den auditorischen Kortex mit dem mittleren temporalen Gyrus und dem temporalen Pol, der wiederum mit dem inferioren frontalen Gyrus verbunden ist. Diese Bahn ist für die Erkennung von Geräuschen zuständig und wird daher auch als auditive „Was“-Bahn bezeichnet. Zu den Funktionen des AVS gehören die folgenden.

GeräuscherkennungBearbeiten

Sammelnde, konvergierende Hinweise deuten darauf hin, dass das AVS an der Erkennung auditiver Objekte beteiligt ist. Auf der Ebene des primären auditorischen Kortex zeigten Aufzeichnungen von Affen einen höheren Prozentsatz von Neuronen, die für gelernte melodische Sequenzen selektiv sind, im Areal R als im Areal A1, und eine Studie am Menschen zeigte eine größere Selektivität für gehörte Silben im anterioren Heschl’schen Gyrus (Areal hR) als im posterioren Heschl’schen Gyrus (Areal hA1). In den nachgelagerten assoziativen Hörfeldern berichteten Studien sowohl bei Affen als auch bei Menschen, dass die Grenze zwischen dem vorderen und dem hinteren Hörfeld (Abbildung 1 – Gebiet PC beim Affen und mSTG beim Menschen) Tonhöhenmerkmale verarbeitet, die für die Erkennung von Hörobjekten notwendig sind. In einer fMRT-Studie an Affen wurde außerdem die Selektivität der anterioren Hörfelder für kon-spezifische Vokalisationen durch intrakortikale Aufzeichnungen nachgewiesen. und funktionelle Bildgebung. Die Rolle des menschlichen mSTG-aSTG bei der Geräuscherkennung wurde durch Studien zur funktionellen Bildgebung nachgewiesen, bei denen die Aktivität in dieser Region mit der Isolierung von auditorischen Objekten von Hintergrundgeräuschen und mit der Erkennung von gesprochenen Wörtern, Stimmen, Melodien, Umweltgeräuschen und nicht-sprachlichen kommunikativen Geräuschen korreliert wurde. Eine Meta-Analyse von fMRI-Studien zeigte außerdem eine funktionelle Dissoziation zwischen dem linken mSTG und dem aSTG, wobei ersteres kurze Spracheinheiten (Phoneme) und letzteres längere Einheiten (z. B. Wörter, Umgebungsgeräusche) verarbeitet. In einer Studie, in der die neuronale Aktivität des linken pSTG und des aSTG direkt aufgezeichnet wurde, wurde berichtet, dass das aSTG, nicht aber das pSTG, aktiver war, wenn die Patientin Sprache in ihrer Muttersprache hörte und nicht in einer ihr unbekannten Fremdsprache. Folgerichtig führte die Elektrostimulation des aSTG bei dieser Patientin zu einer Beeinträchtigung der Sprachwahrnehmung (siehe auch ähnliche Ergebnisse). Intrakortikale Aufzeichnungen aus dem rechten und linken aSTG zeigten außerdem, dass Sprache lateral zur Musik verarbeitet wird. Eine fMRT-Studie an einem Patienten mit gestörter Geräuscherkennung (auditorische Agnosie) aufgrund einer Hirnstammschädigung zeigte ebenfalls eine reduzierte Aktivierung in den Bereichen hR und aSTG beider Hemisphären beim Hören von gesprochenen Wörtern und Umweltgeräuschen. Aufzeichnungen aus dem anterioren auditorischen Kortex von Affen, während sie gelernte Geräusche im Arbeitsgedächtnis behalten, und die schwächenden Auswirkungen induzierter Läsionen dieser Region auf den Abruf aus dem Arbeitsgedächtnis weisen darauf hin, dass das AVS die wahrgenommenen auditorischen Objekte im Arbeitsgedächtnis behält. Die letztgenannte Studie hat außerdem gezeigt, dass das Arbeitsgedächtnis im AVS für die akustischen Eigenschaften gesprochener Wörter zuständig ist und dass es unabhängig vom Arbeitsgedächtnis im ADS ist, das die innere Sprache vermittelt. Untersuchungen des Arbeitsgedächtnisses bei Affen deuten auch darauf hin, dass bei Affen, im Gegensatz zum Menschen, das AVS der dominante Arbeitsgedächtnisspeicher ist.

Beim Menschen wird angenommen, dass das MTG und das TP, die dem aSTG nachgeschaltet sind, das semantische Lexikon bilden, das ein Langzeitspeicher für audio-visuelle Repräsentationen ist, die auf der Grundlage semantischer Beziehungen miteinander verbunden sind. (Siehe auch die Übersichten, in denen dieses Thema behandelt wird). Der wichtigste Beweis für diese Rolle des MTG-TP ist, dass bei Patienten mit einer Schädigung dieser Region (z. B. bei Patienten mit semantischer Demenz oder Herpes-Simplex-Virus-Enzephalitis) die Fähigkeit, visuelle und auditive Objekte zu beschreiben, beeinträchtigt ist und dass sie dazu neigen, bei der Benennung von Objekten semantische Fehler zu machen (d. h. semantische Paraphasie). Semantische Paraphasien wurden auch bei aphasischen Patienten mit einer Schädigung der linken MTG-TP festgestellt und traten bei nicht aphasischen Patienten nach Elektrostimulation dieser Region auf. oder der zugrunde liegenden weißen Substanzbahn Zwei Meta-Analysen der fMRT-Literatur berichteten auch, dass die anteriore MTG und TP während der semantischen Analyse von Sprache und Text durchweg aktiv waren; und eine Studie mit intrakortikalen Aufzeichnungen korrelierte die neuralen Entladungen in der MTG mit dem Verständnis verständlicher Sätze.

SatzverständnisBearbeiten

Die MTG-TP-Region des AVS scheint nicht nur die Bedeutung von Lauten zu extrahieren, sondern auch eine Rolle beim Satzverständnis zu spielen, möglicherweise durch die Zusammenführung von Konzepten (z. B., Verschmelzen der Begriffe „blau“ und „Hemd“ zum Begriff „blaues Hemd“). Die Rolle des MTG bei der Extraktion von Bedeutungen aus Sätzen wurde in Studien zur funktionellen Bildgebung nachgewiesen, die eine stärkere Aktivierung im vorderen MTG ergaben, wenn richtige Sätze mit Wortlisten, Sätzen in einer Fremd- oder Nonsenssprache, verschlüsselten Sätzen, Sätzen mit semantischen oder syntaktischen Verstößen und satzähnlichen Sequenzen von Umweltgeräuschen verglichen wurden. In einer fMRT-Studie, in der die Teilnehmer eine Geschichte lesen sollten, wurde die Aktivität im anterioren MTG mit der Menge des semantischen und syntaktischen Inhalts jedes Satzes korreliert. Eine EEG-Studie, in der die kortikale Aktivität beim Lesen von Sätzen mit und ohne syntaktische Verstöße bei gesunden Probanden und Patienten mit einer MTG-TP-Schädigung verglichen wurde, kam zu dem Schluss, dass das MTG-TP in beiden Hemisphären an der automatischen (regelbasierten) Phase der syntaktischen Analyse (ELAN-Komponente) beteiligt ist, und dass das linke MTG-TP auch an einer späteren kontrollierten Phase der Syntaxanalyse (P600-Komponente) beteiligt ist. Bei Patienten mit einer Schädigung der MTG-TP-Region wurde auch über eine Beeinträchtigung des Satzverständnisses berichtet. Weitere Informationen zu diesem Thema finden Sie in der Übersichtsarbeit.

BilateralitätBearbeiten

Im Widerspruch zum Wernicke-Lichtheim-Geschwind-Modell, das besagt, dass die Lauterkennung ausschließlich in der linken Hemisphäre stattfindet, erbrachten Studien, die die Eigenschaften der rechten oder linken Hemisphäre isoliert durch einseitige Hemisphärenanästhesie (d. h. das WADA-Verfahren) oder intrakortikale Aufzeichnungen von jeder Hemisphäre untersuchten, den Nachweis, dass die Lauterkennung bilateral verarbeitet wird. Darüber hinaus ergab eine Studie, in der Patienten mit getrennten Hemisphären (d. h. Split-Brain-Patienten) angewiesen wurden, gesprochene Wörter geschriebenen Wörtern zuzuordnen, die der rechten oder linken Hemisphäre vorgelegt wurden, dass der Wortschatz der rechten Hemisphäre fast dem der linken Hemisphäre entspricht (der Wortschatz der rechten Hemisphäre entsprach dem Wortschatz eines gesunden 11-jährigen Kindes). Diese bilaterale Erkennung von Geräuschen steht auch im Einklang mit der Feststellung, dass eine einseitige Läsion des auditorischen Kortex nur selten zu einem Defizit im Hörverständnis (d. h. zu einer auditiven Agnosie) führt, während eine zweite Läsion der verbleibenden Hemisphäre (die Jahre später auftreten kann) dies tut. Schließlich zeigte, wie bereits erwähnt, ein fMRT-Scan eines Patienten mit auditiver Agnosie eine bilaterale reduzierte Aktivierung in den anterioren auditorischen Korten, und eine bilaterale Elektrostimulation dieser Regionen in beiden Hemisphären führte zu einer beeinträchtigten Spracherkennung.

Auditiver dorsaler StromEdit

Der auditive dorsale Strom verbindet den auditorischen Kortex mit dem Parietallappen, der wiederum mit dem inferioren frontalen Gyrus verbunden ist. Sowohl beim Menschen als auch bei nicht-menschlichen Primaten ist der dorsale Hörstrom für die Lokalisierung von Geräuschen verantwortlich und wird daher auch als Hörbahn „wo“ bezeichnet. Beim Menschen ist diese Bahn (vor allem in der linken Hemisphäre) auch für die Sprachproduktion, die Sprachwiederholung, das Lippenlesen und das phonologische Arbeits- und Langzeitgedächtnis verantwortlich.

SprachproduktionBearbeiten

Studien am heutigen Menschen haben gezeigt, dass das ADS eine Rolle bei der Sprachproduktion spielt, insbesondere bei der stimmlichen Äußerung von Objektnamen. So führten in einer Reihe von Studien, in denen subkortikale Fasern direkt stimuliert wurden, Interferenzen im linken pSTG und IPL zu Fehlern bei der Benennung von Objekten und Interferenzen im linken IFG zu einem Sprachstillstand. Magnetische Störungen im pSTG und IFG gesunder Teilnehmer führten ebenfalls zu Sprachfehlern bzw. Sprachstillstand. In einer Studie wurde auch berichtet, dass die elektrische Stimulation des linken IPL die Patienten glauben ließ, sie hätten gesprochen, obwohl dies nicht der Fall war, und dass die Stimulation des IFG die Patienten veranlasste, ihre Lippen unbewusst zu bewegen. Der Beitrag des ADS zum Prozess der Artikulation von Objektnamen könnte vom Empfang von Afferenzen aus dem semantischen Lexikon des AVS abhängig sein, Intrakortikale elektrische Stimulationsstudien berichteten auch, dass elektrische Interferenzen im posterioren MTG mit einer beeinträchtigten Objektbenennung korrelierten

Vocal mimicryEdit

Obwohl die Schallwahrnehmung in erster Linie dem AVS zugeschrieben wird, scheint das ADS mit verschiedenen Aspekten der Sprachwahrnehmung verbunden zu sein. In einer Metaanalyse von fMRT-Studien (Turkeltaub und Coslett, 2010), in der die auditive Wahrnehmung von Phonemen mit eng verwandten Lauten kontrastiert wurde und die Studien hinsichtlich des erforderlichen Aufmerksamkeitsniveaus bewertet wurden, kamen die Autoren beispielsweise zu dem Schluss, dass die Aufmerksamkeit auf Phoneme mit einer starken Aktivierung in der pSTG-pSTS-Region korreliert. Eine Studie mit intrakortikalen Aufzeichnungen, bei der die Teilnehmer angewiesen wurden, Silben zu identifizieren, korrelierte ebenfalls das Hören jeder Silbe mit ihrem eigenen Aktivierungsmuster im pSTG. Die Beteiligung des ADS sowohl an der Sprachwahrnehmung als auch an der Sprachproduktion wurde in mehreren bahnbrechenden funktionellen Bildgebungsstudien weiter beleuchtet, in denen die Sprachwahrnehmung mit der offenen oder verdeckten Sprachproduktion verglichen wurde. Diese Studien zeigten, dass das pSTS nur während der Sprachwahrnehmung aktiv ist, während das Gebiet Spt sowohl bei der Wahrnehmung als auch bei der Produktion von Sprache aktiv ist. Die Autoren schlossen daraus, dass das pSTS auf das Areal Spt projiziert, das den auditiven Input in artikulatorische Bewegungen umsetzt. Ähnliche Ergebnisse wurden in einer Studie erzielt, in der die Temporal- und Parietallappen der Teilnehmer elektrisch stimuliert wurden. In dieser Studie wurde berichtet, dass die elektrische Stimulation der pSTG-Region das Satzverständnis beeinträchtigt und dass die Stimulation des IPL die Fähigkeit, die Namen von Objekten zu vokalisieren, beeinträchtigt. Die Autoren berichteten auch, dass die Stimulation des Bereichs Spt und des inferioren IPL sowohl bei der Benennung von Objekten als auch beim Sprachverständnis zu Störungen führt. Die Rolle des ADS bei der Sprachwiederholung stimmt auch mit den Ergebnissen anderer Studien zur funktionellen Bildgebung überein, bei denen die Aktivierung während Sprachwiederholungsaufgaben in ADS-Regionen lokalisiert wurde. Eine intrakortikale Aufzeichnungsstudie, bei der die Aktivität in den meisten Temporal-, Parietal- und Frontallappen aufgezeichnet wurde, ergab auch eine Aktivierung im pSTG, Spt, IPL und IFG, wenn die Sprachwiederholung mit der Sprachwahrnehmung verglichen wurde. Neuropsychologische Studien haben außerdem ergeben, dass Personen mit Sprachwiederholungsdefiziten, aber erhaltenem Hörverständnis (d. h. Leitungsaphasie) an einer umschriebenen Schädigung des Spt-IPL-Bereichs oder einer Schädigung der Projektionen leiden, die von diesem Bereich ausgehen und auf den Frontallappen abzielen. Einen Einblick in den Zweck der Sprachwiederholung im ADS geben Längsschnittstudien an Kindern, die das Erlernen von Fremdwörtern mit der Fähigkeit zur Wiederholung von Nonsenswörtern in Verbindung brachten.

SprachüberwachungBearbeiten

Neben der Wiederholung und Produktion von Sprache scheint das ADS auch eine Rolle bei der Überwachung der Qualität der Sprachausgabe zu spielen. Neuroanatomische Beweise deuten darauf hin, dass das ADS mit absteigenden Verbindungen vom IFG zum pSTG ausgestattet ist, die Informationen über die motorische Aktivität (d.h. die entsprechenden Entladungen) im Stimmapparat (Mund, Zunge, Stimmlippen) weiterleiten. Diese Rückmeldung kennzeichnet den während der Sprachproduktion wahrgenommenen Klang als selbst produziert und kann zur Anpassung des Stimmapparats genutzt werden, um die Ähnlichkeit zwischen dem wahrgenommenen und dem ausgestoßenen Ruf zu erhöhen. Beweise für absteigende Verbindungen vom IFG zum pSTG liefert eine Studie, in der das IFG während chirurgischer Eingriffe elektrisch stimuliert wurde und die Ausbreitung der Aktivierung auf die pSTG-pSTS-Spt-Region berichtet wurde, Eine Studie, die die Fähigkeit von Aphasikern mit Schädigung des Frontal-, Parietal- oder Temporallappens verglich, schnell und wiederholt eine Silbenfolge zu artikulieren, ergab, dass eine Schädigung des Frontallappens die Artikulation sowohl identischer Silbenfolgen („Bababa“) als auch nicht-identischer Silbenfolgen („Badaga“) beeinträchtigte, während Patienten mit Schädigung des Temporal- oder Parietallappens nur beim Artikulieren nicht-identischer Silbenfolgen eine Beeinträchtigung aufwiesen. Da die Patienten mit Schädigung des Schläfen- und Scheitellappens in der Lage waren, die Silbenfolge in der ersten Aufgabe zu wiederholen, scheint ihre Sprachwahrnehmung und -produktion relativ gut erhalten zu sein, und ihr Defizit in der zweiten Aufgabe ist daher auf eine gestörte Überwachung zurückzuführen. In einer fMRT-Studie, die die Rolle der absteigenden ADS-Verbindungen bei der Überwachung ausgestoßener Rufe demonstriert, wurden die Teilnehmer angewiesen, unter normalen Bedingungen oder beim Hören einer modifizierten Version ihrer eigenen Stimme (verzögerter erster Formante) zu sprechen, und es wurde berichtet, dass das Hören einer verzerrten Version der eigenen Stimme zu einer erhöhten Aktivierung im pSTG führt. Ein weiterer Beleg dafür, dass die ADS das motorische Feedback während der Nachahmung erleichtert, ist eine Studie mit intrakortikalen Aufzeichnungen, in der Sprachwahrnehmung und -wiederholung gegenübergestellt wurden. Die Autoren berichteten, dass zusätzlich zur Aktivierung im IPL und IFG die Sprachwiederholung durch eine stärkere Aktivierung im pSTG gekennzeichnet ist als während der Sprachwahrnehmung.

Integration von Phonemen mit LippenbewegungenEdit

Obwohl die Schallwahrnehmung in erster Linie dem AVS zugeschrieben wird, scheint das ADS mit mehreren Aspekten der Sprachwahrnehmung verbunden zu sein. So kamen die Autoren in einer Meta-Analyse von fMRI-Studien, in denen die auditive Wahrnehmung von Phonemen mit eng verwandten Lauten kontrastiert wurde und die Studien hinsichtlich des erforderlichen Aufmerksamkeitsniveaus bewertet wurden, zu dem Schluss, dass die Aufmerksamkeit auf Phoneme mit einer starken Aktivierung in der pSTG-pSTS-Region korreliert. Eine Studie mit intrakortikalen Aufzeichnungen, bei der die Teilnehmer angewiesen wurden, Silben zu identifizieren, korrelierte ebenfalls das Hören jeder Silbe mit ihrem eigenen Aktivierungsmuster im pSTG. In Übereinstimmung mit der Rolle des ADS bei der Unterscheidung von Phonemen haben Studien die Integration von Phonemen und ihren entsprechenden Lippenbewegungen (d. h. Visemen) dem pSTS des ADS zugeschrieben. In einer fMRI-Studie wurde beispielsweise die Aktivierung der pSTS mit der McGurk-Illusion korreliert (bei der das Hören der Silbe „ba“ und das Sehen des Visems „ga“ zur Wahrnehmung der Silbe „da“ führt). In einer anderen Studie wurde festgestellt, dass die McGurk-Illusion noch stärker gestört wird, wenn die Verarbeitung in diesem Bereich durch Magnetstimulation gestört wird. Der Zusammenhang zwischen der pSTS und der audiovisuellen Integration von Sprache wurde auch in einer Studie nachgewiesen, in der den Teilnehmern Bilder von Gesichtern und gesprochenen Wörtern unterschiedlicher Qualität präsentiert wurden. In der Studie wurde berichtet, dass die pSTS für die kombinierte Steigerung der Klarheit von Gesichtern und gesprochenen Wörtern selektiert. Eine fMRT-Studie, in der die Wahrnehmung von audiovisueller Sprache mit audiovisueller Nicht-Sprache (Bilder und Geräusche von Werkzeugen) verglichen wurde, lieferte weitere Belege. In dieser Studie wurden sprachselektive Kompartimente im pSTS nachgewiesen. Darüber hinaus wurde in einer fMRI-Studie, in der kongruente audiovisuelle Sprache mit inkongruenter Sprache (Bilder von unbewegten Gesichtern) verglichen wurde, eine Aktivierung des pSTS festgestellt. Eine Übersicht über weitere konvergierende Belege für die Rolle des pSTS und des ADS bei der Phonem-Visem-Integration finden Sie unter

Phonologisches LangzeitgedächtnisEdit

Eine wachsende Zahl von Belegen deutet darauf hin, dass der Mensch nicht nur über einen Langzeitspeicher für Wortbedeutungen verfügt, der sich im MTG-TP des AVS (d.h., (d.h. das semantische Lexikon), auch einen Langzeitspeicher für die Namen von Objekten in der Spt-IPL-Region des ADS (d.h. das phonologische Lexikon) haben. In einer Studie, in der Patienten mit einer Schädigung des AVS (MTG-Schädigung) oder des ADS (IPL-Schädigung) untersucht wurden, wurde beispielsweise berichtet, dass eine MTG-Schädigung dazu führt, dass die Betroffenen Objekte falsch benennen (z. B. eine „Ziege“ als „Schaf“ bezeichnen, ein Beispiel für semantische Paraphasie). Umgekehrt führt eine IPL-Schädigung dazu, dass Personen das Objekt zwar richtig identifizieren, den Namen aber falsch aussprechen (z. B. „gof“ statt „Ziege“ sagen, ein Beispiel für phonemische Paraphasie). Semantische Paraphasie-Fehler wurden auch bei Patienten berichtet, die eine intrakortikale elektrische Stimulation des AVS (MTG) erhielten, und phonemische Paraphasie-Fehler wurden bei Patienten berichtet, deren ADS (pSTG, Spt und IPL) intrakortikal elektrisch stimuliert wurde. Ein weiterer Beleg für die Rolle des ADS bei der Benennung von Objekten ist eine MEG-Studie, in der Aktivitäten in der IPL während des Erlernens und Abrufens von Objektnamen lokalisiert wurden. Eine Studie, bei der magnetische Interferenzen in den IPL der Teilnehmer induziert wurden, während sie Fragen zu einem Objekt beantworteten, ergab, dass die Teilnehmer in der Lage waren, Fragen zu den Eigenschaften oder Wahrnehmungsmerkmalen des Objekts zu beantworten, aber beeinträchtigt waren, wenn sie gefragt wurden, ob das Wort zwei oder drei Silben enthielt. In einer MEG-Studie wurde auch eine Korrelation zwischen der Erholung von Anomie (einer Störung, die durch eine beeinträchtigte Fähigkeit, Objekte zu benennen, gekennzeichnet ist) und Veränderungen in der IPL-Aktivierung festgestellt. Ein weiterer Beleg für die Rolle der IPL bei der Kodierung von Wortlauten sind Studien, die zeigen, dass Bilinguale im Vergleich zu Monolingualen eine größere kortikale Dichte in der IPL, nicht aber im MTG aufweisen. Da es Hinweise darauf gibt, dass bei Zweisprachigen verschiedene phonologische Repräsentationen desselben Wortes dieselbe semantische Repräsentation teilen, bestätigt diese erhöhte Dichte in der IPL die Existenz des phonologischen Lexikons: Das semantische Lexikon von Zweisprachigen sollte ähnlich groß sein wie das semantische Lexikon von Einsprachigen, während ihr phonologisches Lexikon doppelt so groß sein sollte. In Übereinstimmung mit diesem Ergebnis korreliert die kortikale Dichte in der IPL von Einsprachigen ebenfalls mit der Größe des Wortschatzes. Die funktionelle Dissoziation von AVS und ADS bei Objektbenennungsaufgaben wird insbesondere durch kumulative Belege aus der Leseforschung gestützt, die zeigen, dass semantische Fehler mit einer Beeinträchtigung des MTG und phonemische Fehler mit einer Beeinträchtigung der IPL korrelieren. Auf der Grundlage dieser Assoziationen wurde die semantische Analyse von Texten mit dem inferior-temporalen Gyrus und dem MTG in Verbindung gebracht, und die phonologische Analyse von Texten mit dem pSTG-Spt- IPL

Phonologisches ArbeitsgedächtnisEdit

Das Arbeitsgedächtnis wird häufig als die vorübergehende Aktivierung der im Langzeitgedächtnis gespeicherten Repräsentationen behandelt, die für die Sprache verwendet werden (phonologische Repräsentationen). Diese gemeinsame Nutzung von Ressourcen zwischen Arbeitsgedächtnis und Sprache wird durch den Befund deutlich, dass Sprechen während des Probens zu einer signifikanten Reduktion der Anzahl von Elementen führt, die aus dem Arbeitsgedächtnis abgerufen werden können (artikulatorische Suppression). Die Beteiligung des phonologischen Lexikons am Arbeitsgedächtnis wird auch durch die Tendenz von Personen belegt, mehr Fehler zu machen, wenn sie Wörter aus einer kürzlich gelernten Liste phonologisch ähnlicher Wörter abrufen als aus einer Liste phonologisch unähnlicher Wörter (phonologischer Ähnlichkeitseffekt). Studien haben auch ergeben, dass Sprachfehler, die beim Lesen begangen werden, den Sprachfehlern, die beim Abrufen von kürzlich gelernten, phonologisch ähnlichen Wörtern aus dem Arbeitsgedächtnis gemacht werden, bemerkenswert ähnlich sind. Schließlich ist die Ansicht, dass das verbale Arbeitsgedächtnis das Ergebnis einer vorübergehenden Aktivierung phonologischer Repräsentationen im ADS ist, mit neueren Modellen vereinbar, die das Arbeitsgedächtnis als Kombination aus der Aufrechterhaltung von Repräsentationen im Aufmerksamkeitsmechanismus und der vorübergehenden Aktivierung von Repräsentationen im Langzeitgedächtnis beschreiben. Es wurde argumentiert, dass die Rolle des ADS bei der Wiederholung von Wortlisten der Grund dafür ist, dass dieser Pfad während des Satzverständnisses aktiv ist. Für einen Überblick über die Rolle des ADS im Arbeitsgedächtnis siehe